编者按:匿名数据的大规模聚合分析会生成有价值的结果和洞见,这不仅可以揭示出公共健康所面临的挑战,而且可以为新的科学发现提供契机。这些分析方法能够拓展我们的知识范围并有助于提升人类健康与福祉。然而,相应的问题随之而来:在这项技术为个体以及社会整体带来福利的同时,如何准确评估它们对隐私构成的潜在威胁?机器学习能够利用信息和社会数据从非医疗数据中推测出人类健康状态以及潜在风险这一实例,可以为我们如何保持创新与规则之间的平衡提供很好的范本。

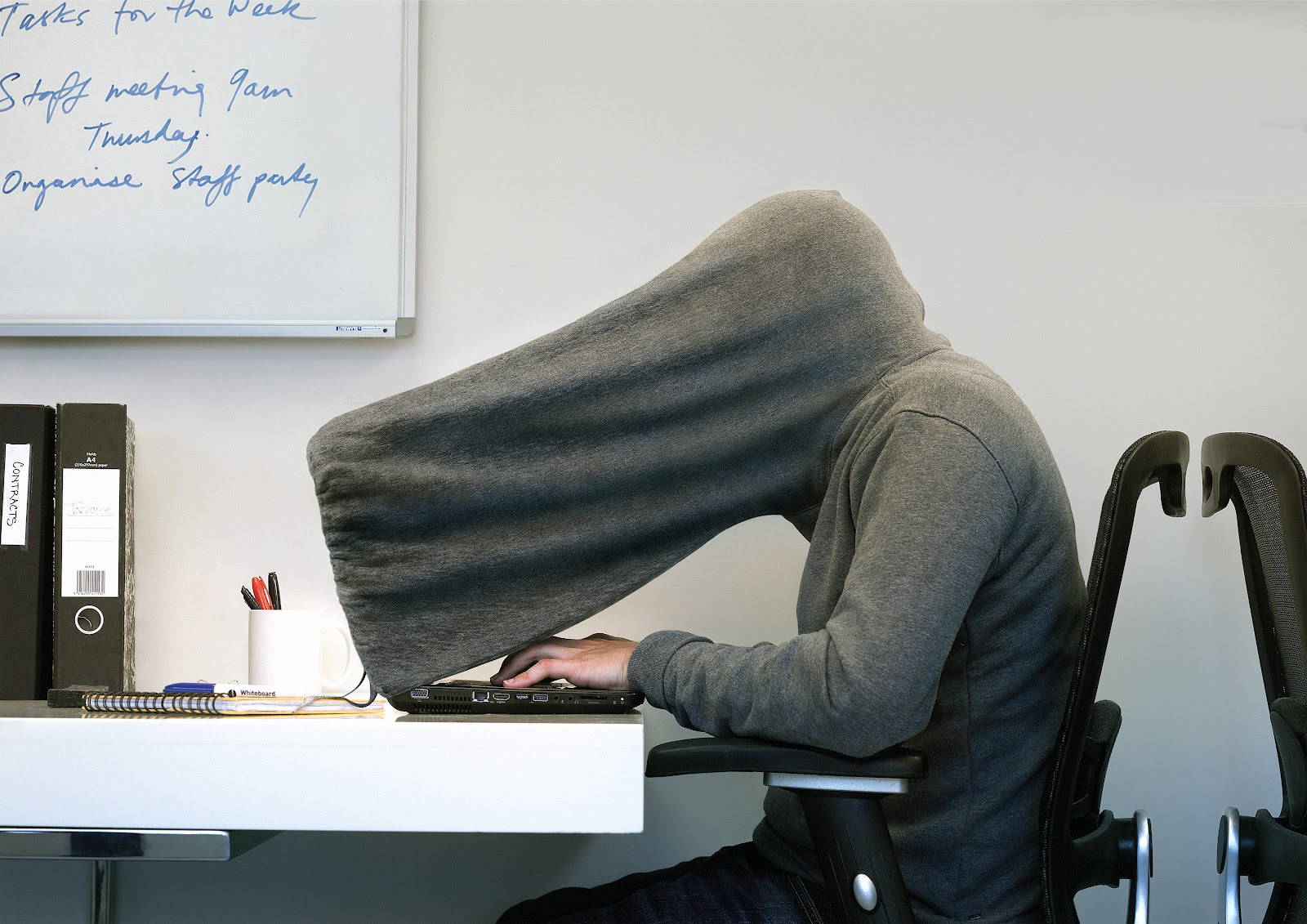

如果分析Twitter状态或者Facebook帖子可以识别可能患有产后抑郁症的新妈妈,会发生什么?尽管产后抑郁症会带来严重后果,然而早期识别和预防仍然困难重重。因为无抑郁症病史,早期识别在很大程度上依赖于新妈妈们的自述。但是,研究人员发现,Facebook上一系列行为和用语的改变可以预测产后抑郁症(如图)。社会化媒体和其他数字化数据流产生了关于个人和群体的海量数据流,那些以此为基础,通过机器学习获取和利用与健康有关的预测的研究可谓前途无量,预测产后抑郁是其中之一。与此同时,机器学习也对保护个人隐私和确保数据的合理使用提出了新挑战。我们必须在控制信息收集和数据使用之间取得平衡,也要追求可审计、可靠的技术和系统以增强基于使用的隐私保护。

机器学习能够对健康进行跨类预测。社交媒体上,新妈妈们的行为和语言使用能够被用来预测是否产后抑郁。

研究人员创造了一些术语,例如数字疾病检测和信息监测 ,来定义这类利用不同的数字信息流进行公共卫生和政策信息通报的新科学,例如流行病的早期识别,疾病的传染性和流动性建模,个人疾病风险分类等。这种新形式的健康研究也会扩展那些由传统健康记录和人体试验得出的结论。比如,药物不良反应的检测可以结合美国食品和药物管理局的不良反应报告系统及匿名搜索日志加以改善。搜索日志可以作为一个大规模的传感系统,用来监测药物安全——药物警戒。

信息监测研究通常是指对公开披露或私有匿名数据的大规模综合分析,就人群中公共健康问题得出结论和见解。然而,一些方法和模型可以针对特定个体加以推测,从而采取一些举措来改善个体或公共健康状况,例如警报或者进行数字干预(digital nudging)。

尽管数字干预显示出良好前景,但是,英国最近发生的一次事件,让人们注意到它也会对隐私造成困扰。Good Samaritan是Twitter上一款预防自杀的应用,通过监测用户在Twitter上的用语,这款应用能够预测该用户患有精神疾病的风险并通知该用户的关注者,以便他们能介入以避免可能发生的自杀。但是,这项技术令舆论哗然,也引发监管机构的担忧,随后被关闭。批评人士担心,这款应用会鼓励在线骚扰者和恃强凌弱者将矛头指向这些脆弱个体,他们的请愿书指出,这款应用收集、处理并分享敏感信息,侵犯了用户隐私,并收集到了1200个志愿者。虽然开发者预防自杀的初衷值得嘉奖,但是,此项非盈利之举却因它将试图拯救的那些人的隐私和精神健康视为儿戏而遭到训斥。

机器学习可以促进信息环境与社会环境之间的交流,借助远超医疗环境的非医疗数据就健康状况或者倾向做出跨类推测(category-jumping)。这对隐私的影响是深远的。跨类推测可能会揭露一个人特意向别人隐瞒的问题或状况。为了防止出现这些违背意愿的现象,美国对健康护理隐私严加监管。但是,虽然从健康理疗和支付中获得的健康状况信息能够以一种尊重患者隐私的方式加以保护,但是,机器学习和推测可以绕开许多现存的保护机制。

即使不是跨类推测,机器学习也能从自我揭露、看似良性的数据以及易于观察的行为中,进行强大而折衷的推论( powerful and compromising inferences)。这些结论可能会与隐私法的根本目的相悖——个人有权决定谁知道以及知道自己哪些隐私。机器学习和预测会让人们越来越难判断:根据自己或明或暗共享过的信息,他人有权获知自己的哪些隐私。这些计算机收集健康状况的信息渠道与其他技术手段联手之后,会让既有健康隐私的保护机制出现很大漏洞。特别是,面对大量可以用来再次识别个体的各种辅助性数据,我们很难将公开分享过的数据组去识别化(deidentify)。

现有的美国隐私制度将个人健康状态隐私保护与被先验确定为健康信息的特定文本或特定信息类型关联起来,机器学习的威力让这种规定的根本局限性无所遁形。现有美国健康隐私规则和隐私法律都是基于这一假设:孤立环境中的数据语义相对固定并且可知。但是,机器学习却被用来从数据、跨数据中来预测新的数据语义,通常不受美国隐私法约束。例如,使用Twitter上的公开推文来预测产后抑郁症风险,这并不违反现有的隐私法。由于文章是公开共享的,这样做可能并不会让人吃惊,也似乎不成问题,但是,这种预测行为也会导致令人不安的后果。

当前的隐私法通常采用双重责任(double duty)。作为基本原则,法律会限制有权访问个人信息的主体。这也间接限制了信息能够影响决策的范围,因此也进一步限制了信息引发歧视的机会。出于对隐私的高度敏感以及健康方面歧视的关注,还另立法律,对健康医疗数据文本之外的健康信息使用紧行规制。美国法律明确限制了不当使用健康信息的行为。例如, 决定就业、信贷或住房时,法律通常禁止信用报告机构提供医疗信息。《美国残疾人法案》(ADA)禁止身体或精神残疾歧视,甚至不允许人们这么认为个体备受残疾折磨。如果机器学习被用来推断某人患有身体或精神障碍,那么,即使推断是错误的,雇主据此决定聘用对方的行为也违反了法律。

但是,《美国残疾人法》并不禁止歧视残疾倾向(predispositions)。机器学习也能发现那些残疾倾向。理论上,《禁止基因信息歧视法案》(GINA)应该通过保护基因上具有残疾倾向的人来填补这一空白。但是,机器学习又让这种保护变得困难。尽管GINA禁止以基因测试或某种疾病的家族遗传史等信息为基础的歧视,但是,机器学习能从其他类型数据中发现这些残疾倾向,GINA并未限制人们利用这些信息进行歧视(即使它还是根植于基因问题)。换句话说,机器学习能从非基因信息(包括遗传倾向引发的健康变化)中预测未来的健康状况,规避现有法律。

正如机器学习会暴露隐私一样,它也为社会分类——对人分门别类,不同类别不同待遇——提供条件,无论这种处理的初衷如何(善或恶、好或坏)。为了将个体纳入公共健康计划和干预机制,对其进行分门别类的方法也能轻易地被用于邪恶的目的,例如,通过歧视来保护组织的利益。

美国和其他国家的决策者们刚刚开始着手梳理机器学习预测对信守隐私、公平带来的挑战。白宫公布了一份报告,讨论了大规模数据分析可能导致歧视,虽然没有特别关注健康信息,但是,报告和美国联邦贸易委员会(FTC)都建议采取新举措来保护隐私、整治恶意使用信息并增加透明度。

FTC是监管商业活动中不公平、欺诈性交易的关键部门,包括那些涉及隐私与个人信息安全的商业活动。试行的隐私政策鼓励公司将技术与政策机制结合来,防止再次识别(reidentification)。试行规定力图确保数据「不能进行合理识别」,也要求上市公司(public company)承诺不会再次识别经过反识别处理的数据。试行也适用于数据下游使用者。这一政策方针有望适用于机器学习以及以数据为中心的分析领域中来。通过鼓励公司减少数据池和数据分享对个人隐私造成的风险,使对大量数据组的学习和数据分享成为可能。

FTC的规定部分取材于机构近期采取的一些行动,行动焦点正是我们谓之「文本跨越(context-jumping)」的预测行为。有一个颇受关注的案例,Netflix公开一批数据组支持竞争以改善公司的推荐算法。当公司以外的研究人员用辅助数据重新识别、推测来自Netflix数据组的个体敏感特征时,FTC与Netflix合作,对将来公开预测结果进行了限制——FTC上述限制规定正是源于此。遵循类似脉络,FTC反对改变Facebook的默认规定:可以根据已经公开的个体隶属组别中的敏感信息,诸如政治观点和性别取向,进行预测。

除此之外,FTC也努力确保个体能够控制在线跟踪以及移动网络环境。部分是因为人们可以从巨大的数据集合中进行比较隐秘的推测,给用户带来风险,比如,市场活动中,用户会被分门别类地予以特殊对待。在某相关规定中,FTC建议国会要求数据掮客(data brokers)——那些搜集用户个人信息予以出售或分享的公司——向客户清楚说明他们搜集的数据信息并如实告知客户,公司从这些数据中得到了一些预测。这里,FTC再次表明,它的关注点不仅仅是原始数据,还包括基于这些数据作出的预测。

奥巴马政府的大数据计划也考虑到机器学习给隐私造成的威胁以及机器推测在市场活动中带来的潜在威胁,计划总结道,我们需要更新隐私政策,提高消费者保护和民主权利机构的技术专业性以描述出大数据引发的新奇的歧视议题,并为个体提供隐私保护工具,让公民可以控制、管理个人信息管理,增加公司使用和交易数据的透明度。政府也关心机器学习在政策与国家安全方面的使用情况。白宫报告要求提高专业技术,帮助民主权利和消费者保护机构识别、调查以及消弭会对受保护阶层带来歧视效应的大数据分析使用。

请注意,政府报告和法律规定清楚强调了政策规范关注的是数据使用,而不是数据收集。尽管我们也需要工具来帮助用户控制自身数据收集的时间和方式,但是,政府的建议是让个体有权参与到如何使用与公开搜集到的数据的决策过程中来。总统科技顾问委员会(PCAST)出具的一份独立报告的结论是,技术保护这个方向更加富有成效。两份报告均建议,基于数据使用的保护能更好地描述出潜在数据意义——使用机器学习对数据进行预测——也能适应数据丰富规模以及将来的关联环境。 政府呼吁各方通力合作以确保对健康数据文本的规制使以下期待成为可能:享受机器学习和预测的好处的同时降低其可能招致的风险。这种基于数据使用的保护方法也经常得到工业领域的支持,该领域倾向于将数据视为一种自然资源,无论是出于商业目的还是公共利益,都要对之进行开采,抵制限制数据搜集的举措。

尽管当前陷入僵局的国会不太可能,也不会完全依从这些建议,但是,采用它们会增强数据搜集、使用以及相应后果的透明度。连同努力识别、限制不公平或歧视性数据的使用和推测等建议,它们都是颇为有用的举措。这些建议也与欧盟目前有关数据处理透明度与公平性的隐私法律,特别是全自动化决策可能给个体造成的风险方面,步调一致。

目前欧盟的法律要求实体为个人提供获得决策数据的途径以及决策标准的信息【参看第21款第12条和第15条】。尽管目前有欧盟统一指令约束,但是,具体规定仍是各国法律的事情。当个体要求获取数据和进行加工时,他们能够获取的权限大小会随着各国对「全自动化 」过程施加限制的不同而所有不同。欧盟想要采用一项高于本地法律的数据隐私规定,实行单一国家标准。尽管现有草案包含平行条款,但是,最终版本以及如何进行最终解释都尚不清楚(27)。

理论上,欧盟提出了一项新要求来公开数据的处理逻辑,这可以得到广泛适用,同时也预示着将有公开途径获得数据分析及算法。欧盟将基于当前欧盟的统一指令,就获取数据和处理逻辑的程度补充一些细节,在这之前的过渡期,今年夏天将有望出台一项决议。

对数据拥有者来说,提高数据处理的透明度至关重要又颇具挑战。尽管这一目标会促进我们加深对运作方式或机器学习和推理方法的可能输出结果的实际理解,但是,算法和决策标准的工作流和机制或许难以进行描绘和解释。例如,流行的卷积神经网络学习程序能够自动催发丰富的、多层的表征,但对于这些表征,可能开发者自己都无法清晰理解。尽管可以提供对步骤和表征的高级描述,但是,即便是一个能够取得源码的娴熟程序员, 也无法对这一系统的准确运行进行描述,无法对一组既定输入值的输出结果进行准确预测。

数据的意义已经成为了一个不断移动的目标。数据集可以通过去定义化被轻易的组合成重新定义的数据集,感知知识可从常规和杂乱分享的良性数据中推断出来。这对目前美国利用合法手段进行隐私保护造成了困难,他们的保护手段往往是基于数据的可识别性和明确含义对其进行管理。

基于应用的解决方案在一定程度上仅聚焦于有限的数据收集,这是不够的。因为从某种程度上来说,这种做法预设了数据是可被基于某种原则进行收集的纯粹的物品,无论何时何地。虽然我们尚未准备好废弃掉数据收集的限制,但我们对此表示同意——基于应用的管理条例是未来法律蓝图的重要部分,尽管实施起来将面临挑战,但它将有助于促进隐私、平等和公共物品的保护。在提高透明度的同时还要平衡随之而来的各种限制,基于应用的解决方案将需要格外强调个人数据的获取、准确性和修正权利。

尽管关于个人健康信息的管理条例的演化还不完整,但它却提供给了我们一个有价值的图景,使我们能够对今天所面临的机遇和挑战进行思考,同时也为潜在解决方案提出了框架思路。在医疗健康领域,隐私条例中总会包含不歧视条款,同时也伴随着支持研究的特殊条款。如今,隐私条例与集体管理模型联系在了一起,后者的设计初衷是鼓励将支持研究的生物样本库数据进行汇总,同时保护集体隐私。

尽管还有些较为现实的挑战,我们仍希望政策制定者和公众能够就数据、机器学习的能力进行开诚布公的讨论,这将为接下来的程序和政策提供富有洞察力的设计思路,我们一方面需要保护隐私和确保公平,另一方面也需要享受(基于个人数据的)科学研究成果给个人和公众带来的好处,程序和政策的设计有利于在这两者之间取得平衡。我们对隐私和公正的追求是永恒的,我们的政策必须适应这种进步,同时也要支持深化我们认识的新技术。

本文选自Science,机器之心翻译出品。作者:Eric Horvitz、 Deirdre Mulligan 翻译:电子羊、桑夏、孟婷、微胖审核:奇、微胖、赵云峰